tuto | installation et gestion de gfs2

Article publiée le 24 Août 2013

Un système de fichier clusterisé permet le partage d’une partition sur plusieurs machines.

Les avantages d’un tel système de ficher sont nombreux:

– Montage d’un fs sur plusieurs machines différentes

– Performances grandements améliorées

– Gestion de grandes quantités de données

– Meilleur gestion des volumes contenant énormément de petits fichiers

– Bonne gestion des gros fichiers

– Possibilité de gérer des quotas

Ayant testé et même vu le fonctionnement de plusieurs FS clusterisé je dois dire que le système de fichier GFS2 est le plus simple à mettre en place.

Ma philosophie en tant qu’admin système est de mettre en place les solutions les plus économiques, les plus faciles et les plus performantes.

GFS2 (conçu par Red Hat) répond à ces trois critères.

Le tutoriel ci-dessous vous donne la marche à suivre pour mettre en place GFS2.

GFS2 étant un produit de RED HAT, ce tutoriel sera exclusivement effectué via 2 machines CentOS 6.4.

Avant de commencer ce tutoriel assurez vous que votre SAN soit correctement paramétré et vos FS montés.

Assurez vous également que votre serveur DNS est correctement configuré pour résoudre les noms des machines.

Si vous ne disposez pas de serveur DNS administrable, renseignez correctement vos fichiers hosts (/etc/hosts).

Installons les paquets requis:

yum install cman gfs2-utils kmod-dlm modcluster ricci luci cluster-snmp iscsi_initiator-utils openais oddjobs rgmanager

1) Creation Cluster

Commençons par créer un cluster de machine:

Je vous assure cela sera très simple avec l’interface d’administration Web de Luci!

Tout d’abord démarrons tous les service nécessaire au cluster:

Sur votre node 1 (considéré comme le « Master »):

– chkconfig luci on && service luci start

Changez ensuite le mot de passe Unix de Luci:

passwd luci

Sur tout les nodes:

– chkconfig ricci on && service ricci start

– chkconfig gfs2 on && service gfs2 start

– chkconfig cman on && service cman start

Maintenant connectez vous à l’interface Web de Luci:

https://<ip de votre node 1>:8084

Luci est une interface graphique permettant de configurer les fichiers de configuration /etc/cluster/cluster.conf des différents nœuds et de gérer tous les services de clustering.

Entrez vos login root pour accéder à l’interface d’administration:

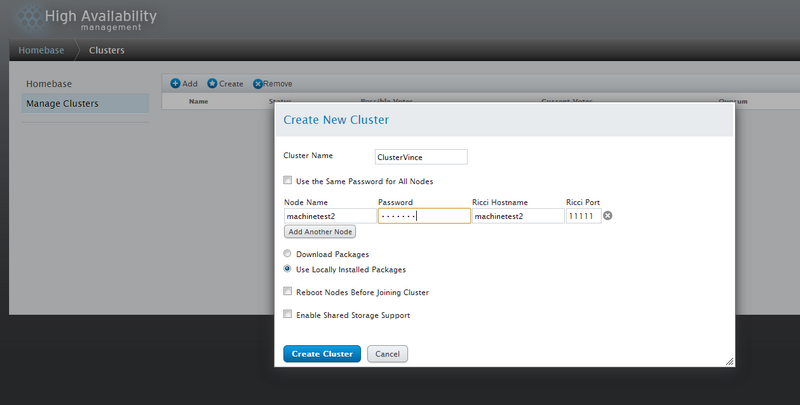

Cliquez sur Create pour créer votre cluster et remplissez les informations. Ajoutez tout vos nœuds sauf celui qui héberge luci qui lui sera ajouté d’office:

Encore une fois vérifiez que votre DNS ou votre fichier hosts soient parfaitement configurés!

Encore une fois vérifiez que votre DNS ou votre fichier hosts soient parfaitement configurés!

Cliquez sur Create Cluster une fois tout vos nœuds saisies.

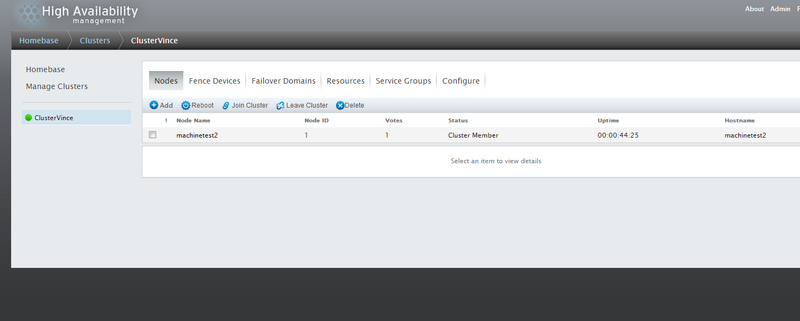

Si tout se passe bien vous devriez avoir un écran ressemblant à la capture ci-dessous:

Ça y’est votre Cluster est créé et opérationnel!

2) Création partition GFS2

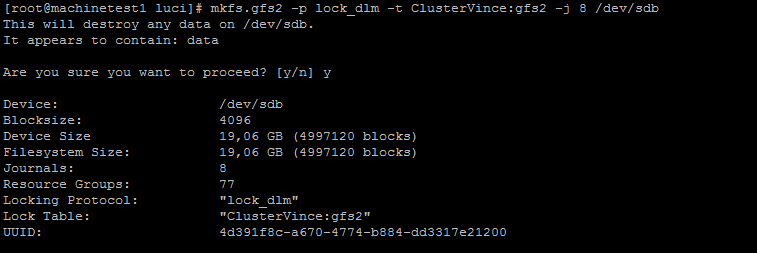

D’abord on crée le FS, pour cela exécutez la commande suivante sur un de vos noeuds:

mkfs.gfs2 -p lock_dlm -t <nom du cluster>:gfs2 -j 8 <chemin de votre volume San>

Exemple:

Une fois ceci terminée il ne reste plus qu’à monter la partition sur tout vos nœuds:

mount -o acl -t gfs2 <chemin de votre volume> <votre point de montage>

Exemple:

mount -o acl -t gfs2 /dev/sdb /mnt/testgfs2/

Voila votre Cluster GFS2 est opérationnel!

Pour faire les choses bien jusqu’au bout n’oubliez pas d’éditez le fstab!

Exemple:

vi /etc/fstab:

/dev/sdb /mnt/testgfs2 gfs2 defaults,acl 0

3) Quelque commande bien utile

Pour monter une partition gfs2 avec le système de quota actif:

gfs2_quota limit -u user -l size <point de montage>

Pour fixer un quota:

gfs2_quota warn -u user -l size <point de montage>

Pour afficher le quota d’un user

gfs2_quota get -u user

Pour afficher le quota d’un volume

gfs2_quota list -f <point de montage>

Pour réparer votre fs gfs2 corrompus:

gfs2_fsck /dev/my_vg/my_gfs

Pour conclure GFS2 est le système de fichier idéal si vous avez besoin d’un partage pouvant gérer un grand nombre de fichier ou une masse importante de données tout en gardant d’excellentes performances.