Article publié le 25 Mai 2013

Mis à jour publié le 24 Mai 2016

Ce tutoriel a été mis à jour pour la sortie de la version 3.x

Nagios/Centreon est pour moi le meilleur système de supervision qui existe. Il est puissant, gratuit avec une énorme communauté qui le maintient.

Maintenant sa mise en place est plus ou moins fastidieuse.

J’ai découvert par hasard que Centreon proposait une édition Entreprise.

La version standard est entièrement gratuite est présente de nombreux avantage

– Téléchargeable sous forme d’ISO centreon Entreprise standard est livré sous forme d’OS complet (basé sur CENTOS) avec tout le système de monitoring préinstallé. Vous installez l’ISO comme un OS Linux et il ne vous restera plus qu’à vous connecter dessus via l’interface web

– Possibilité de souscrire à un support, ce qui est très utile si votre supervision est un élément critique dans votre entreprise

– Des add ons payant comme un système de rapport poussé avec des indicateurs de qualités etc, très utile pour remettre à votre DSI des rapports complets sur la santé de votre SI 😉

En gros Centreon Entreprise Standard vous offre gratuitement une solution de monitoring Centreon clé en main!

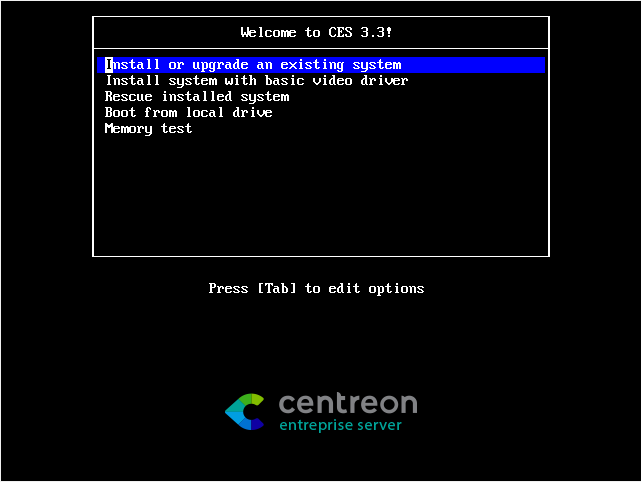

I) Installation

Télécharger l’ISO depuis le site :

http://www.centreon.com/Content-Download/download-centreon-enterprise-server

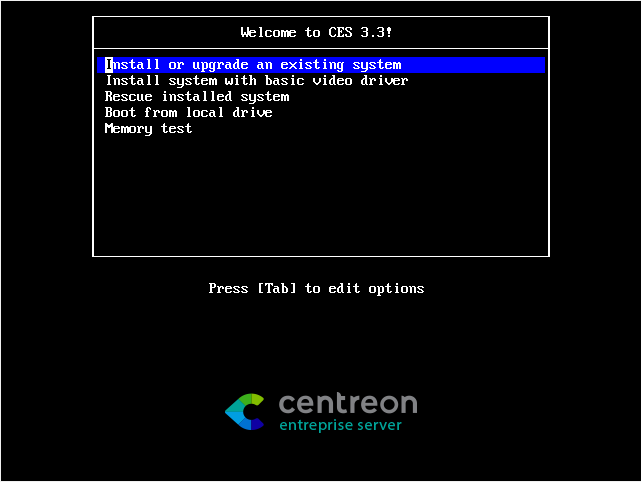

En bootant sur l’image cette interface apparait:

Appuyez sur ENTRER pour une installation par défaut et suivez la procédure normal pour installer un OS linux.

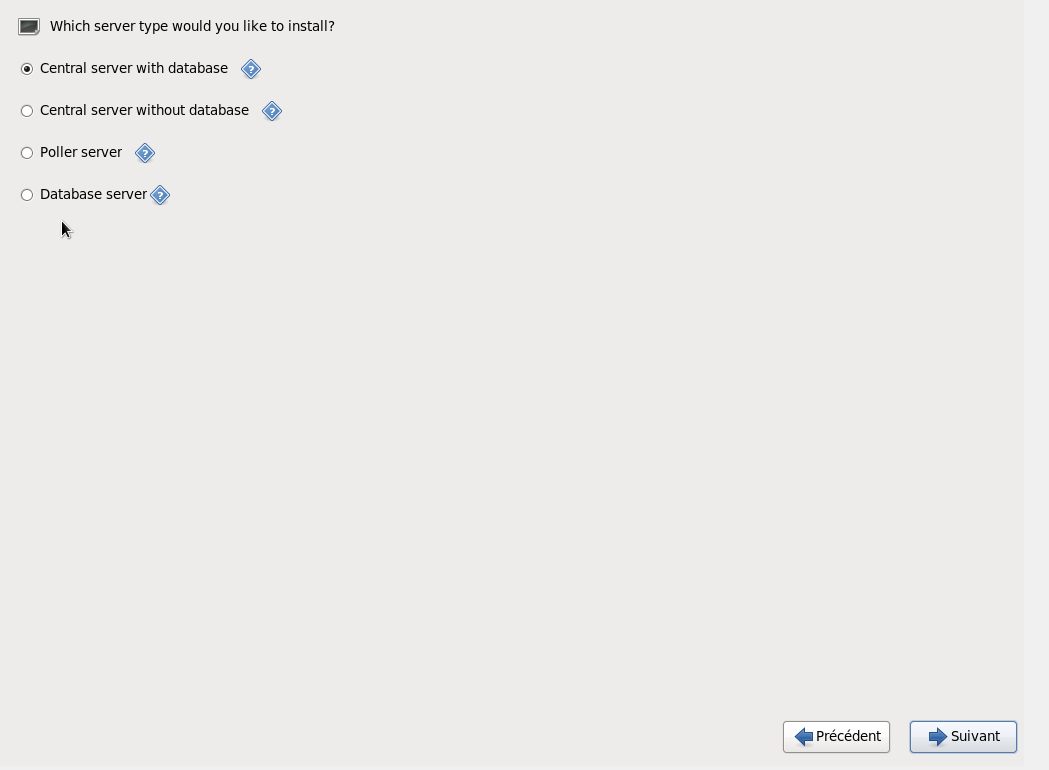

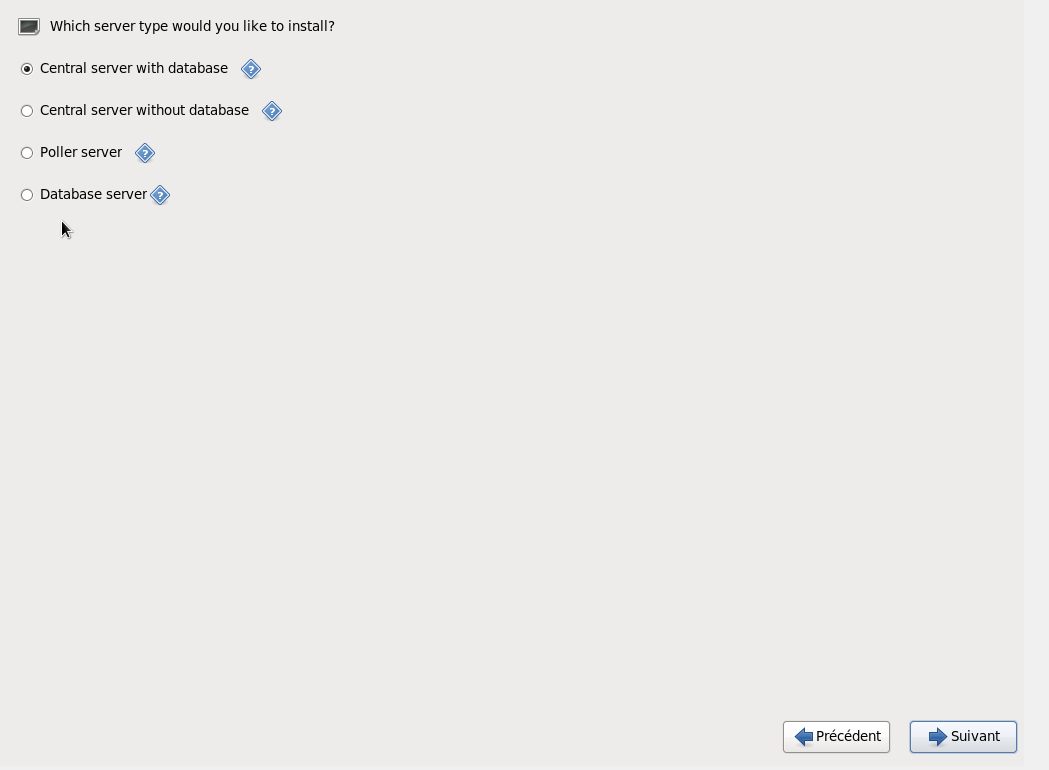

- Petit détail avec la version 3.3 vous pouvez choisir quelle type de serveur installer:

- Si c’est votre première installation, choisissez « Central server with database ».

- « Central server without database » installera Centreon sans la base de données.

- « Poller Server » correspond à un relais Centreon au cas ou votre infrastructure est tellement grande qu’un seul serveur de monitoring ne suffirait pas en terme de ressources.

- « Database Server » correspond à l’installation de la base de donnée uniquement.

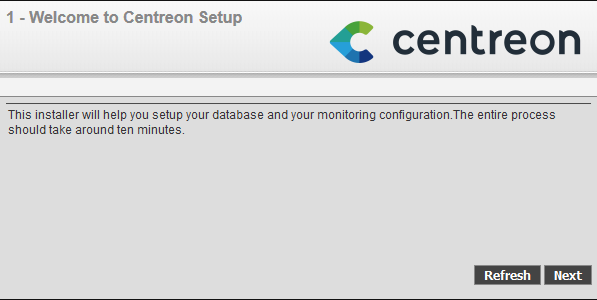

Une fois l’installation terminée connectez vous sur l’interface web (http://<ip_du_serveur>/centreon).

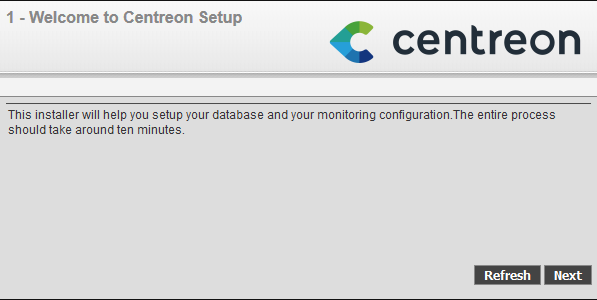

Un assistant de configuration va alors s’afficher:

Cliquez sur suivant:

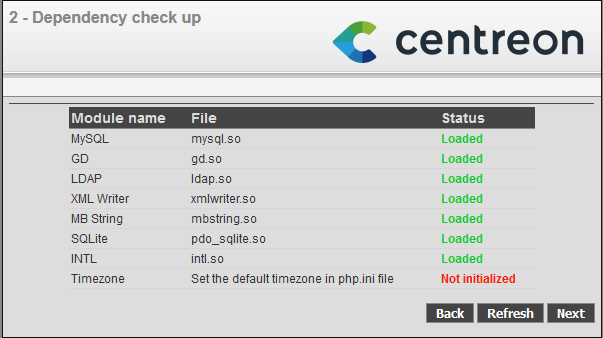

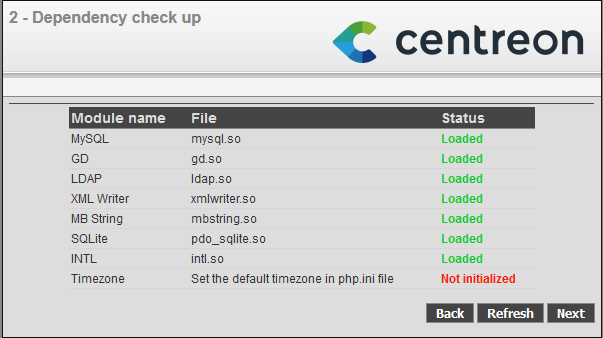

L’écran ci-dessous affiche comme quoi la timezone n’est pas initialisé dans le fichier php.ini (un classique)

Connectez vous sur votre machine et éditez le fichier /etc/php.ini. Modifier la ligne « ;date.timezone = » par « date.timezone = « Europe/Paris » » puis redémarrez http (service https restart).

Cliquez ensuite sur le bouton refresh pour que tout soit au vert puis, cliquez sur le bouton « Next »

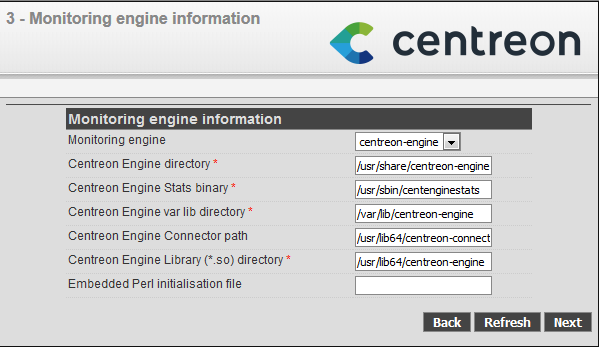

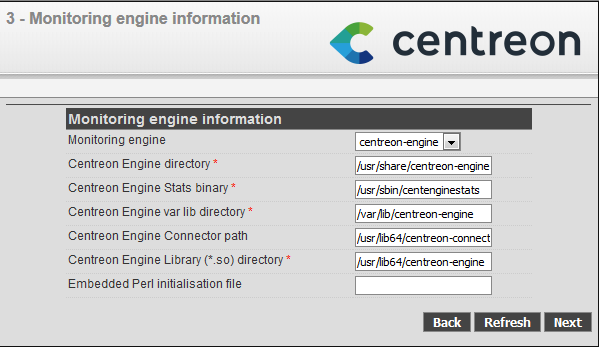

Cliquez sur « Next »:

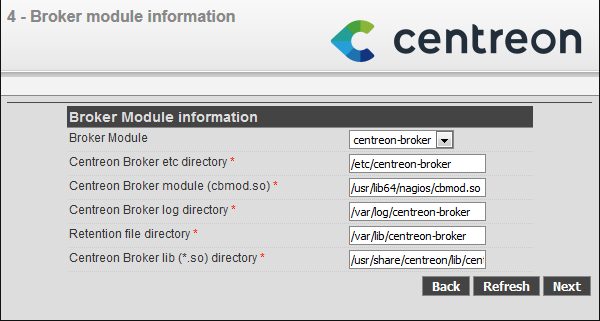

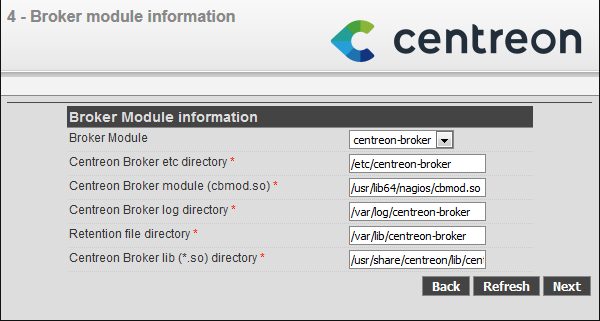

Cliquez sur « Next »:

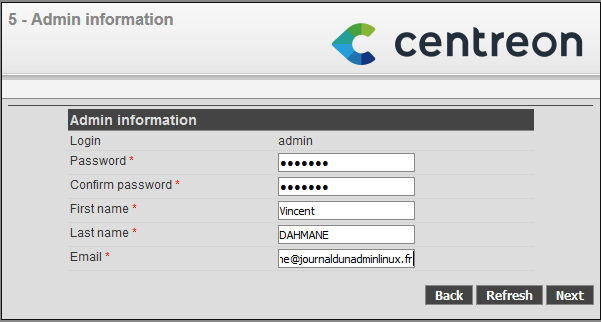

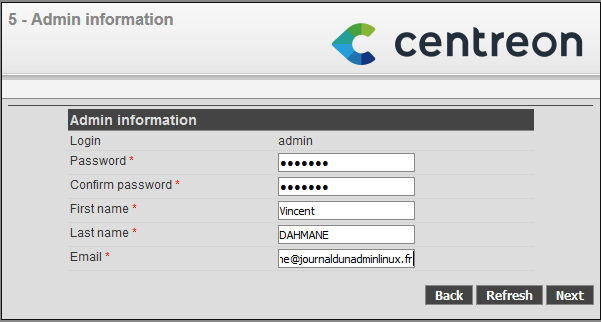

Renseignez les identifiants qui vont vous permettre de vous connectez à l’interface Web ainsi que les informations demandées:

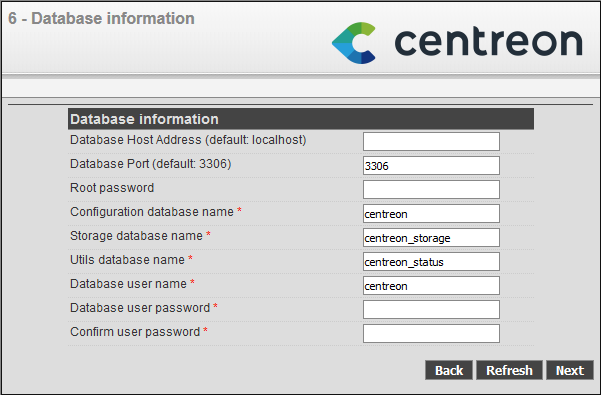

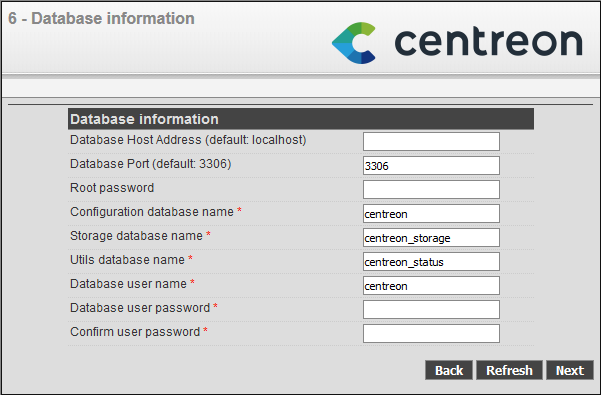

Cliquez sur « Next » après avoir renseigné les mots de passe de base de données

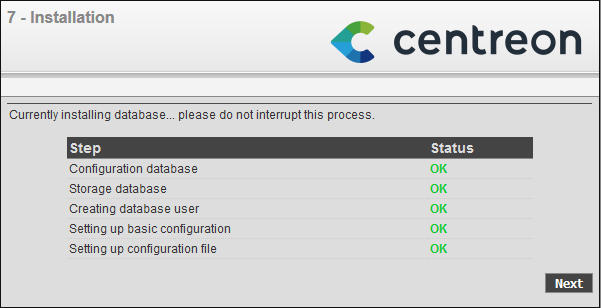

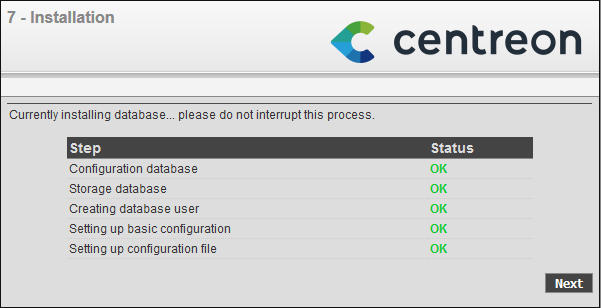

Attendez que l’installation termine puis cliquez sur next:

Connectez vous sur l’interface WEB avec les identifiants renseignés précédemment:

Je vais vous expliquer ci-dessous la logique de Centreon. Rassurez vous il n’y a aucune différence avec les autres outils de monitoring disponible sur le marché!

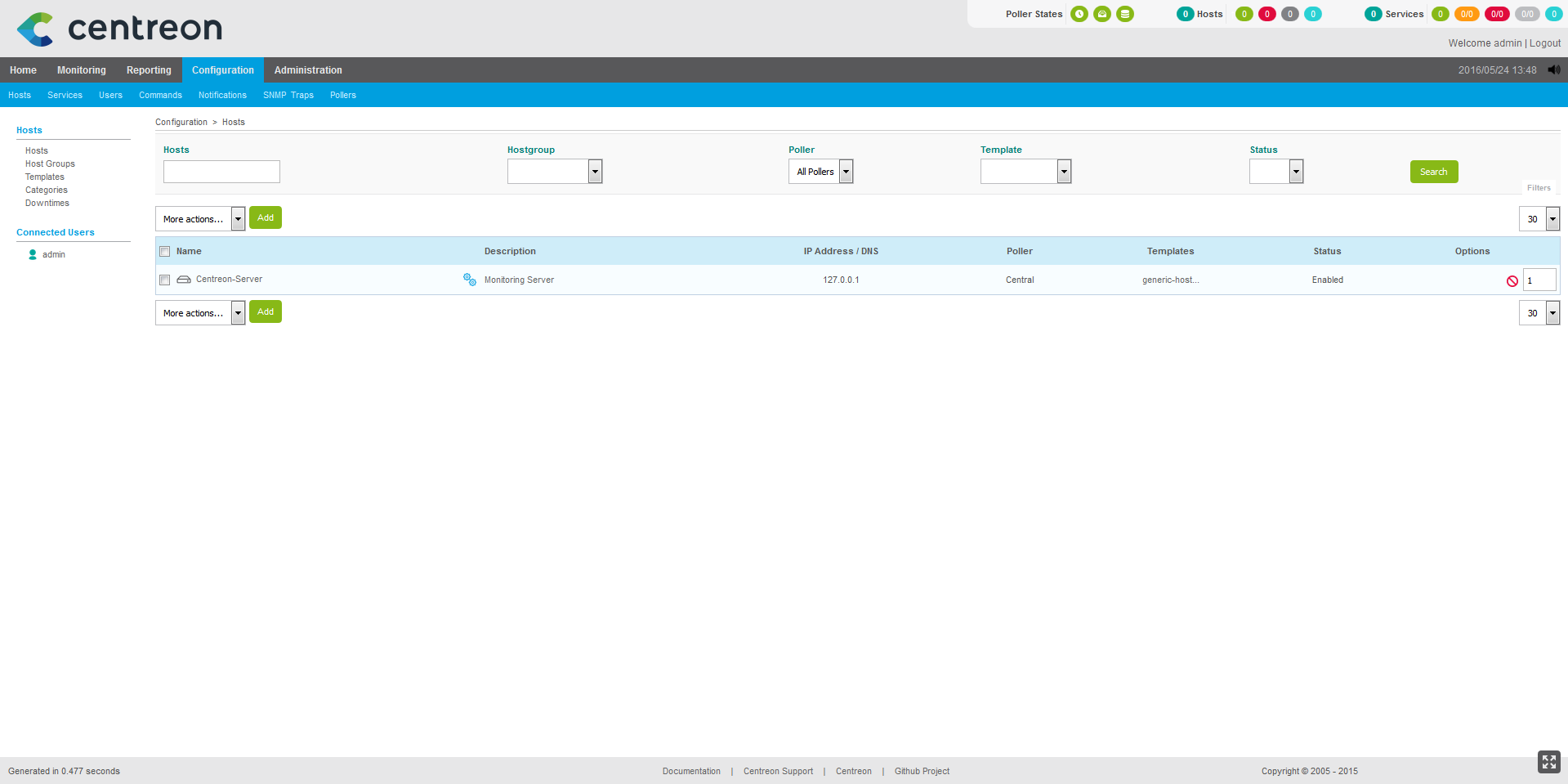

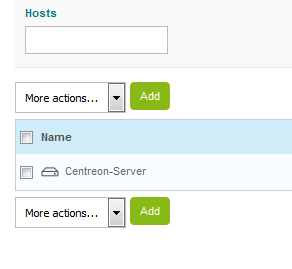

ETAPE 1: Ajout des hosts (machines)

Ceci est la 1er étape, il faut que vous ajoutiez toutes les machines que vous voulez monitorer.

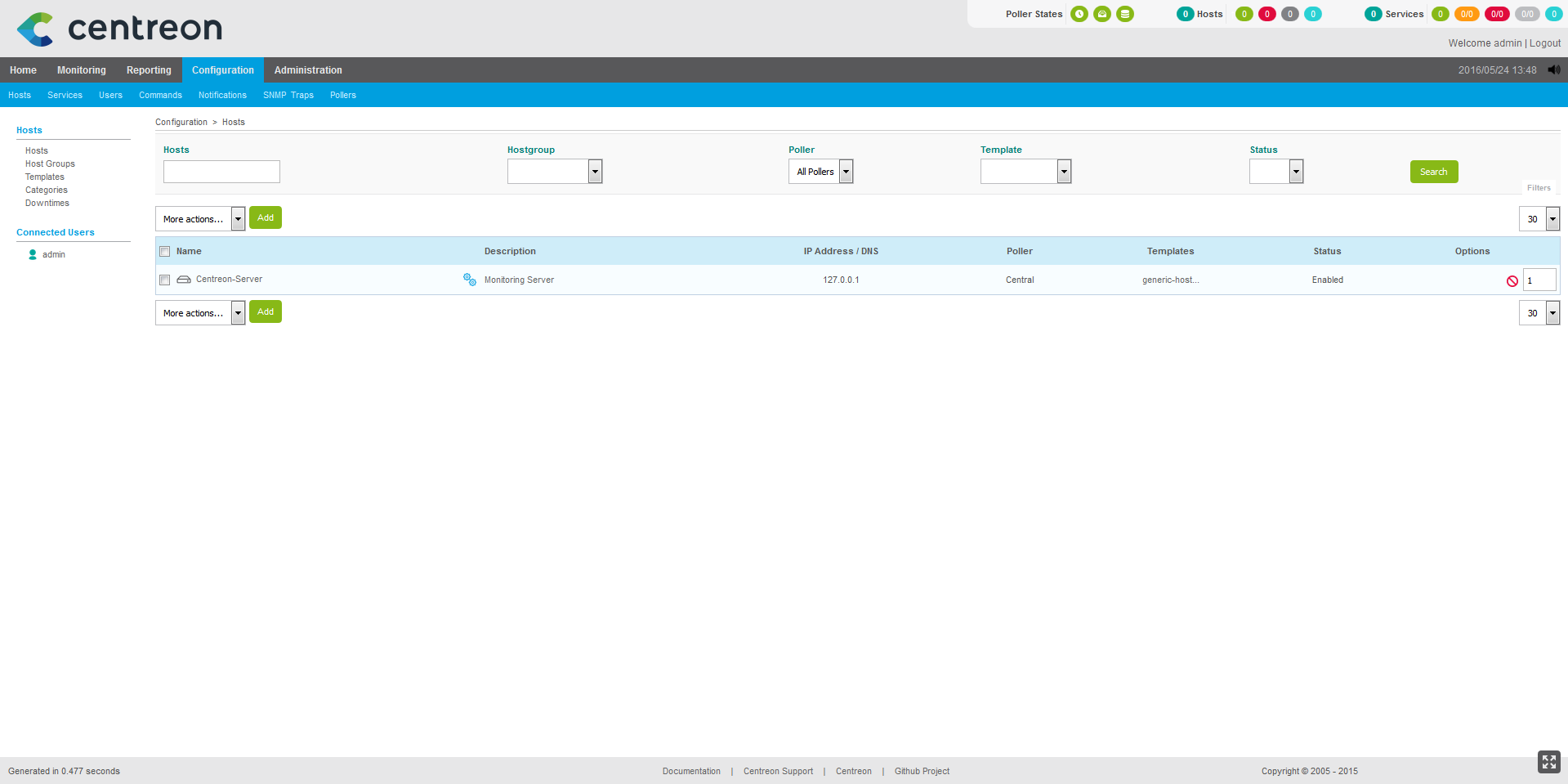

Pour cela connectez vous sur votre interface centreon via l’interface web (http://<ip_du_serveur>/centreon) puis, une fois l’authentification effectuée, cliquez sur « Configuration » et « hosts » comme vous le montre les captures d’écrans ci-dessous:

Une fois sur la section des gestion des hosts cliquez sur le bouton « add »

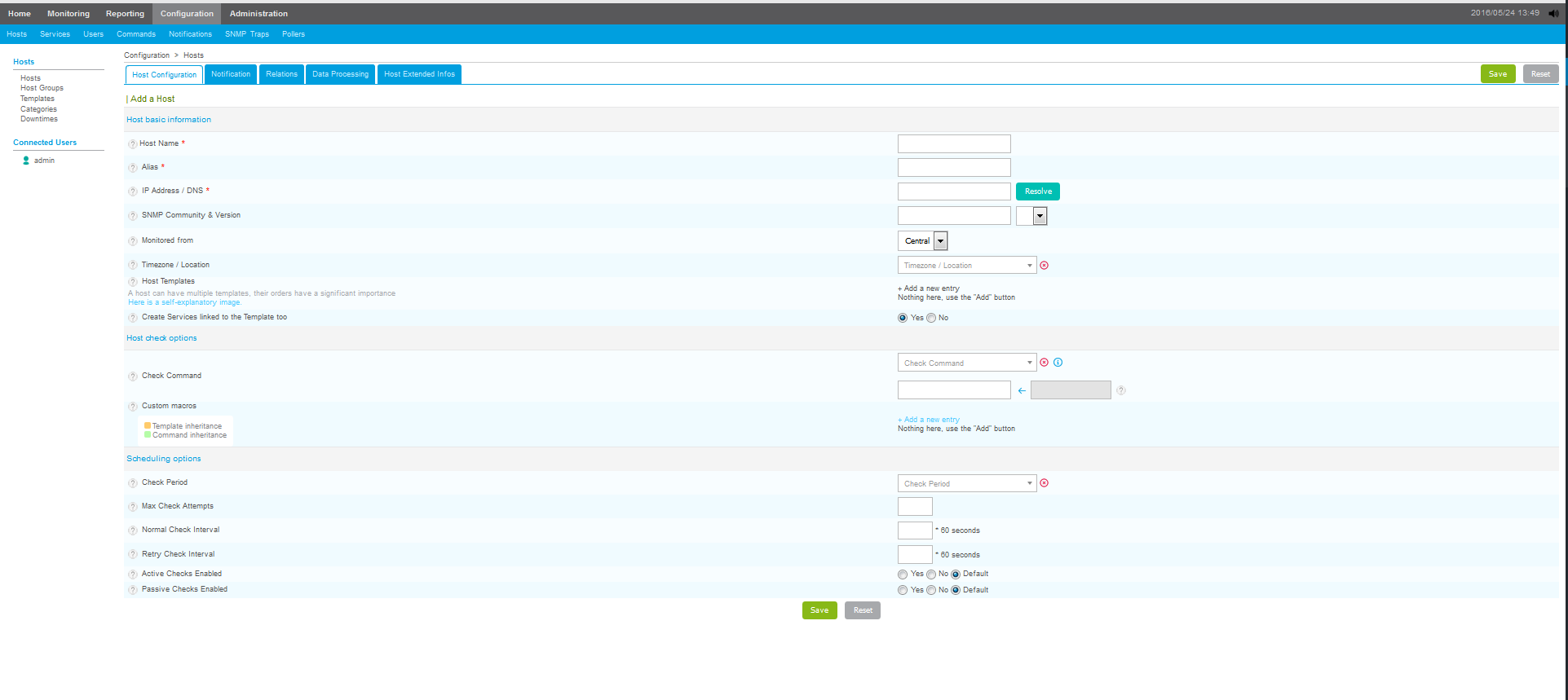

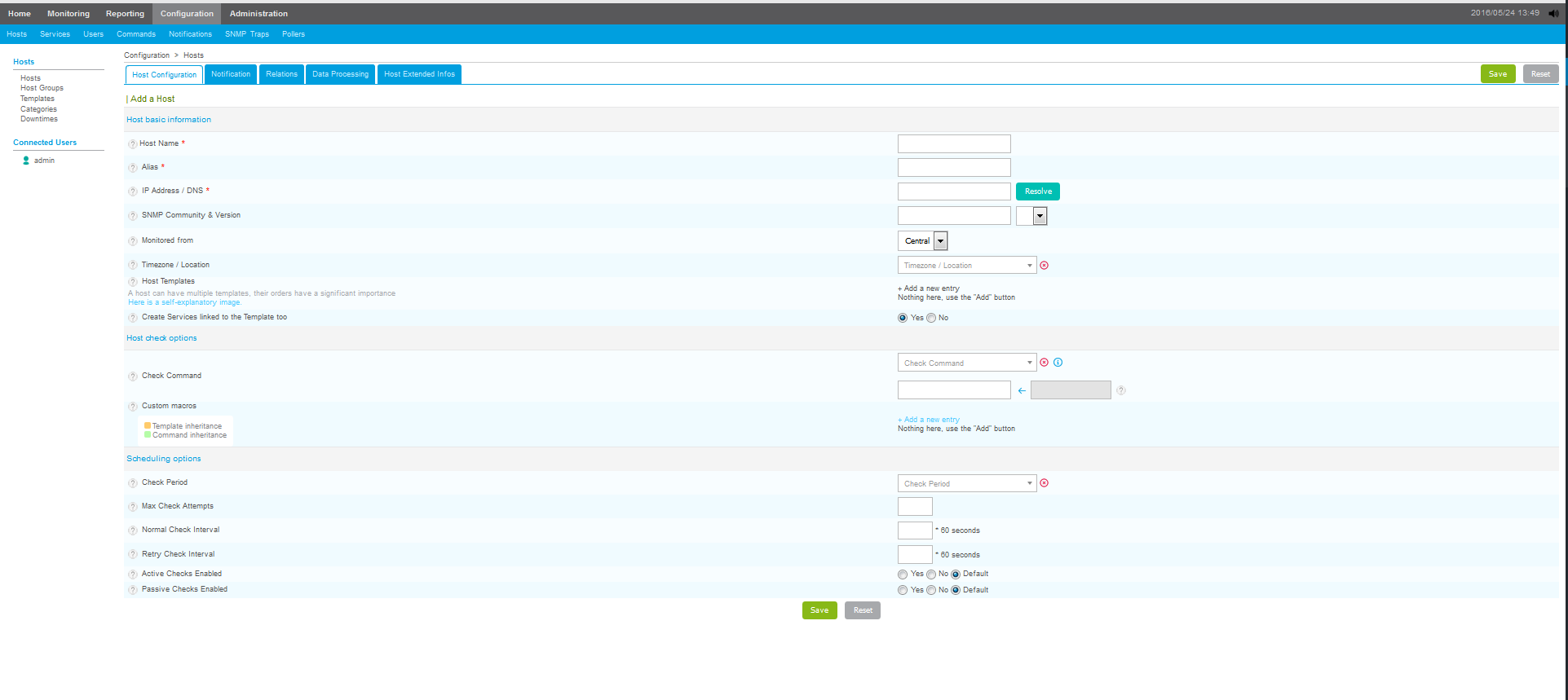

La page suivante apparaît alors:

Renseignez les différents champs renseignant votre machines et validez en cliquant sur « save » en bas de la page.

ETAPE 2: Commandes.

Les commandes sont les scripts qui vont checker les hosts (Charge cpu,mémoire etc). Ces scripts sont situées dans /usr/lib64/nagios/plugins.

Si vous décidez de développer vos propres scripts de supervision, vous devrez les placer dans ce répertoire afin qu’il soit visible sur la page « command » de Centreon.

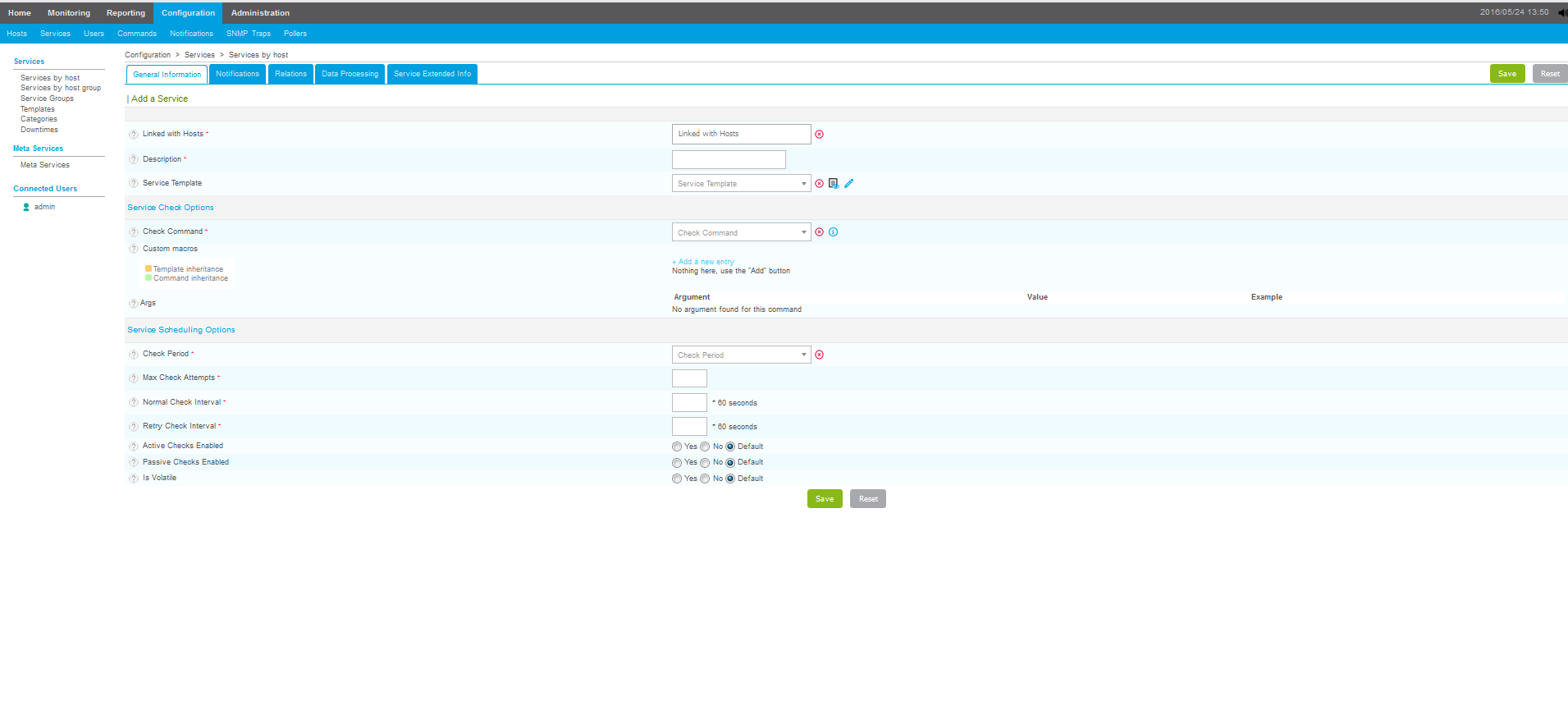

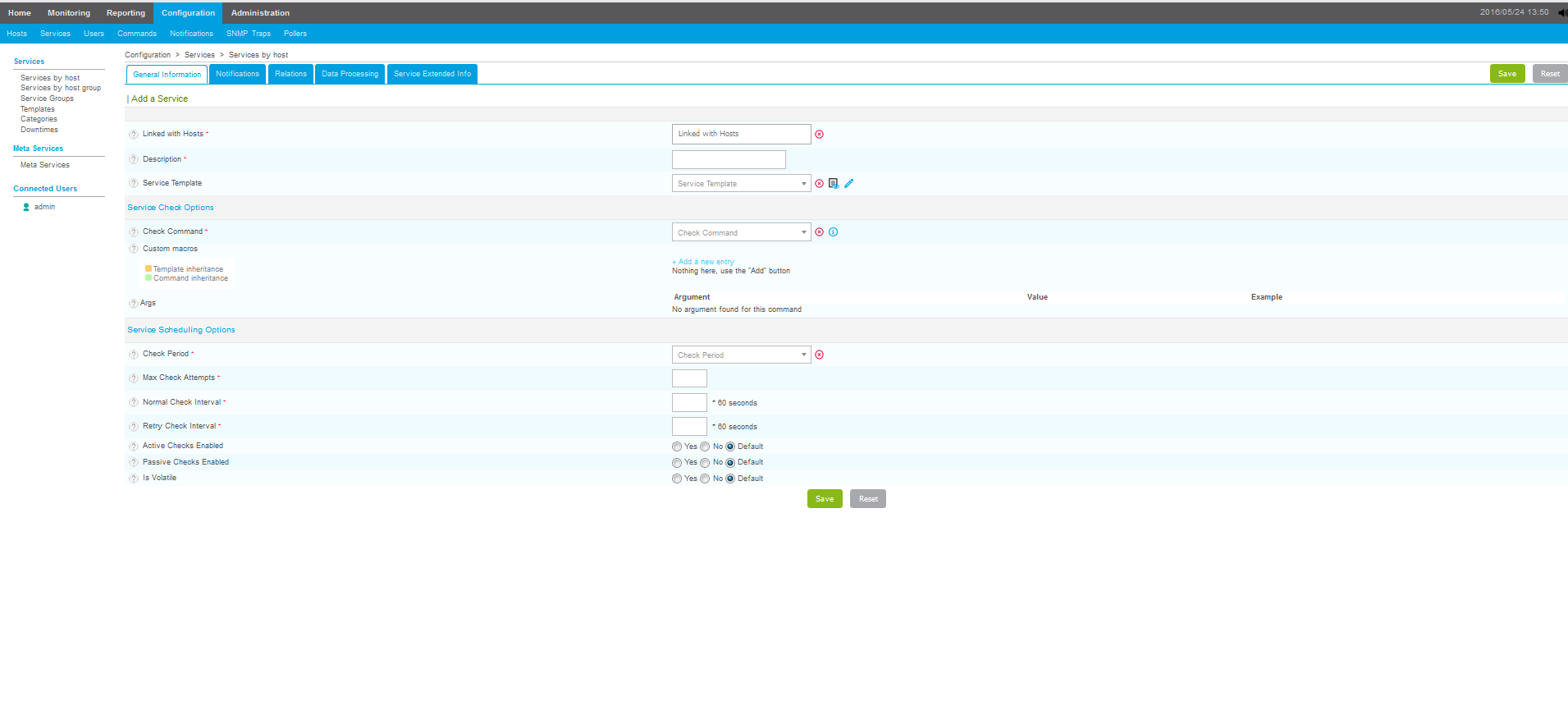

ETAPE 3: Services

Les services représentent ce qui va superviser votre machine. Un service contient une commande. C’est le service qui va exécuter votre script de supervision sur le ou les machines et vous renvoyer le résultat.

Pour configurer un service cliquez sur « configuration » puis « service ».

Une fois sur la page cliquez sur « add » pour créer un nouveau service:

Explication de quelques champs:

« Linked with Hosts »: Afin d’associer votre services aux hosts

« Description »: le nom du service tel qu’il apparaîtra sur votre interface de monitoring

« Check Period »: La période ou le service sera actif.

« Check Command »: La command (le script) qui sera effectuée.

« Args »: si le script contient des arguments des champs apparaîtront. Généralement les arguments correspondent aux seuils d’alerte

« Max Check Attempts »: le nombre de check que va faire le service en cas de problème avant de se mettre en alerte (nombre d’essai). (status autre que « OK »)

« Normal Check Interval »: le temps séparant 2 checks. Par exemple si vous spécifier « 1 », le script sera exécuté toutes les minutes. L’avantage d’avoir un interval minimum est que vous serez alerté très vite en cas de problème. Cependant cela demandera plus de ressources réseau et machine.

« Retry Check Interval »: le temps que met le service à rechercker une machine ayant un statut autre que « OK ».

» Notification Type »: Le type de notification qui sera afficheée par le service.

Cliquez sur « save » une fois votre sélection terminée.

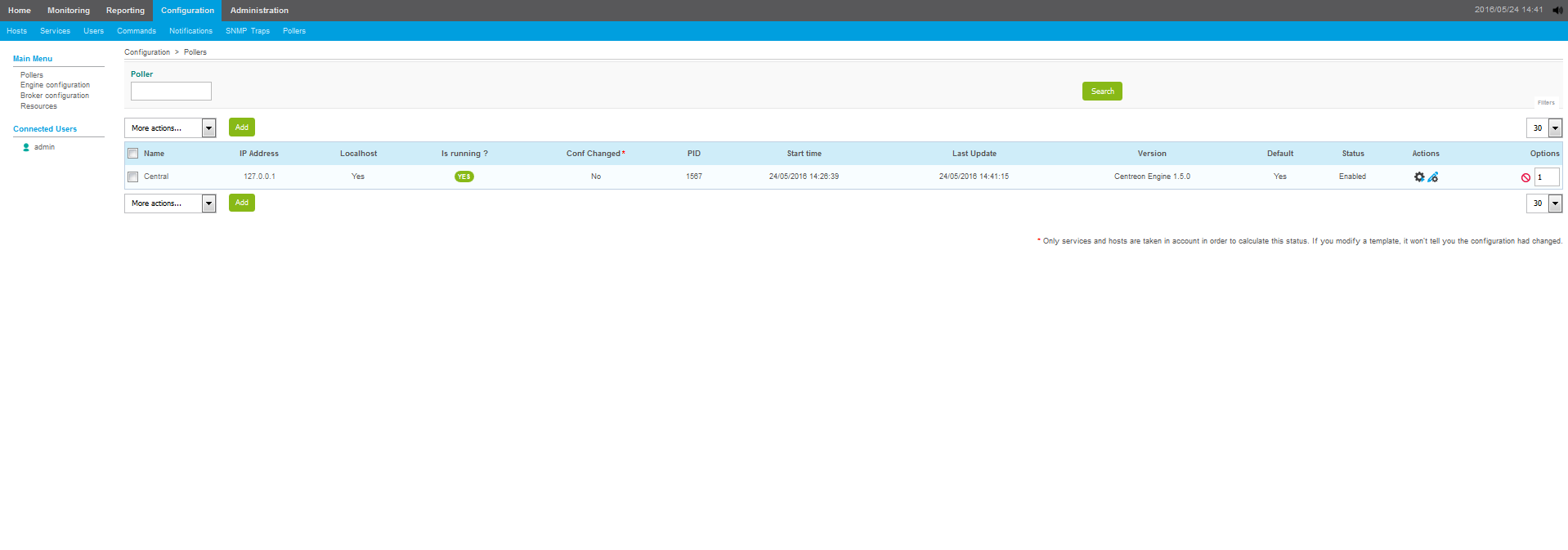

ETAPE 4: Commiter la configuration

Il ne reste plus qu’à faire en sorte que votre configuration soit pris en compte (écriture sur les fichiers de configuration NAGIOS).

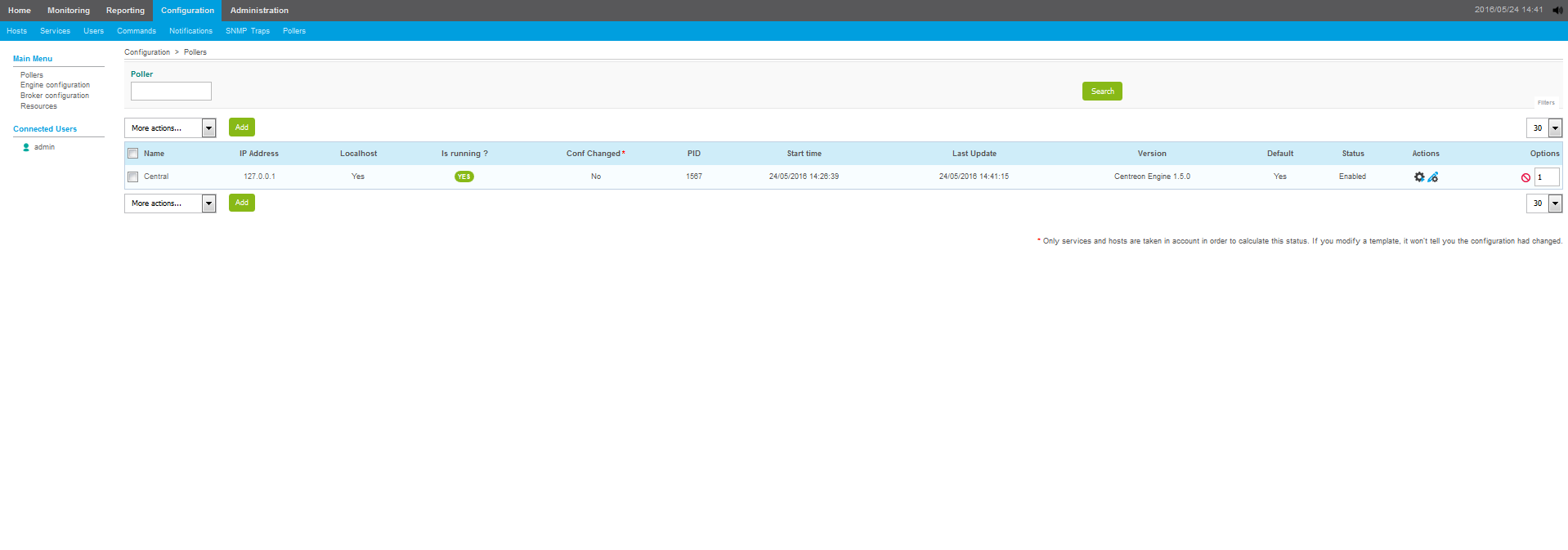

Pour cela cliquez sur « configuration » et « pollers »:

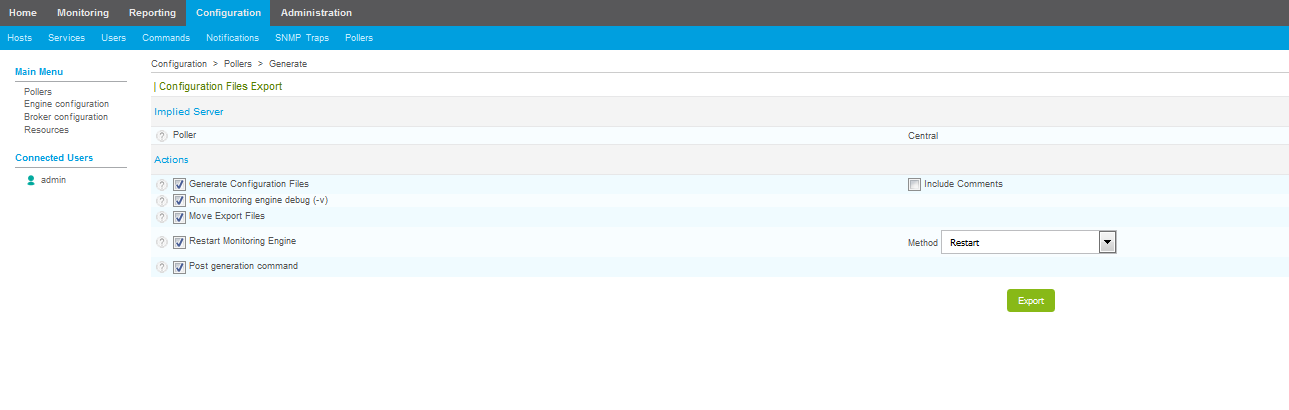

Cliquez ensuite sur l’icône d’engrenage en dessous de « Action »:

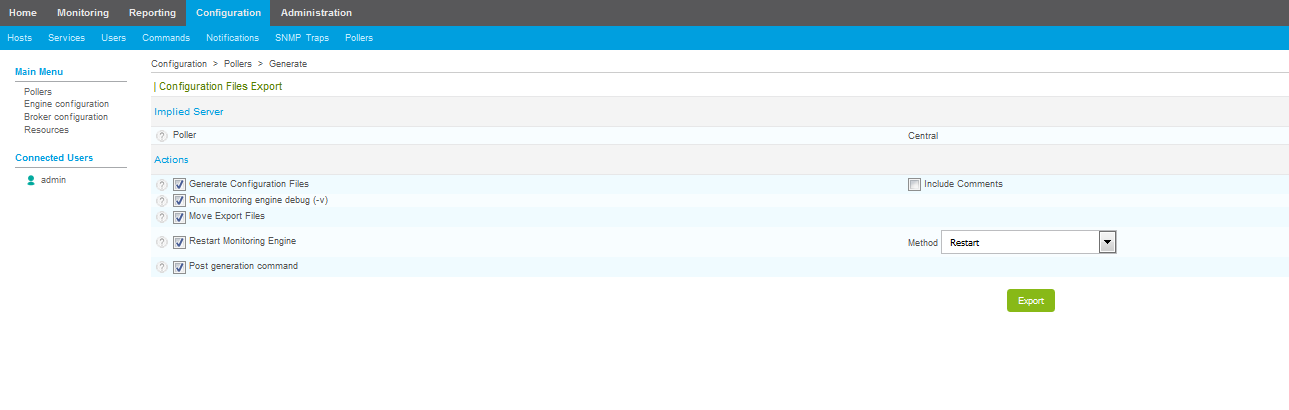

Cochez « Generate Configuration Files », « Restart Monitoring Engine » et « Move Export Files ».

La « méthod » correspond à l’action effectué pour la prise en compte de votre nouvelle configuration: « reload » ou « restart » le service.

Il ne vous reste plus qu’à cliquez sur export pour que la configuration soit écrite en dur sur les fichiers de configuration Nagios.

Cliquez ensuite sur l’onglet « monitoring » en haut de la page puis sur « host » ou « service » en fonction de la vue que vous voulez avoir.

Il ne reste plus qu’à admirer l’état de vos machines!!

Ce tutoriel reprend juste les grandes lignes de l’administration de Centreon. Le nombre de fonctionnalité possible sur Centreon est énorme (liste de contact, notification SMS, etc…) .

L’interface étant assez intuitive, je trouve que la prise en main est rapide.

Comme je l’ai expliqué plus haut Centreon Entreprise Server Standard et la version « gratuite » (très complète). Des éditions payantes contenant des extensions propriétaires sont disponibles sur le site. Ces extensions vous permettent par exemple de générer des rapport pointues, des vues plus poussées, etc…

Je vous conseil également ce site: http://nagios.manubulon.com/

Ce site contient une multitude de scripts de supervision (command) que vous pourrez rajouter.

Certains serveurs dédiés (notamment chez OVH) possèdent une adresse IPv4 et IPv6 sur 2 interfaces. Je tiens à souligner l’importance du paramétrage du firewall sur l’interface IPv6 avec shorewall6 (répertoire de configuration /etc/shorewall6). Un oubli pourrait transformer votre machine en passoire.

Certains serveurs dédiés (notamment chez OVH) possèdent une adresse IPv4 et IPv6 sur 2 interfaces. Je tiens à souligner l’importance du paramétrage du firewall sur l’interface IPv6 avec shorewall6 (répertoire de configuration /etc/shorewall6). Un oubli pourrait transformer votre machine en passoire.

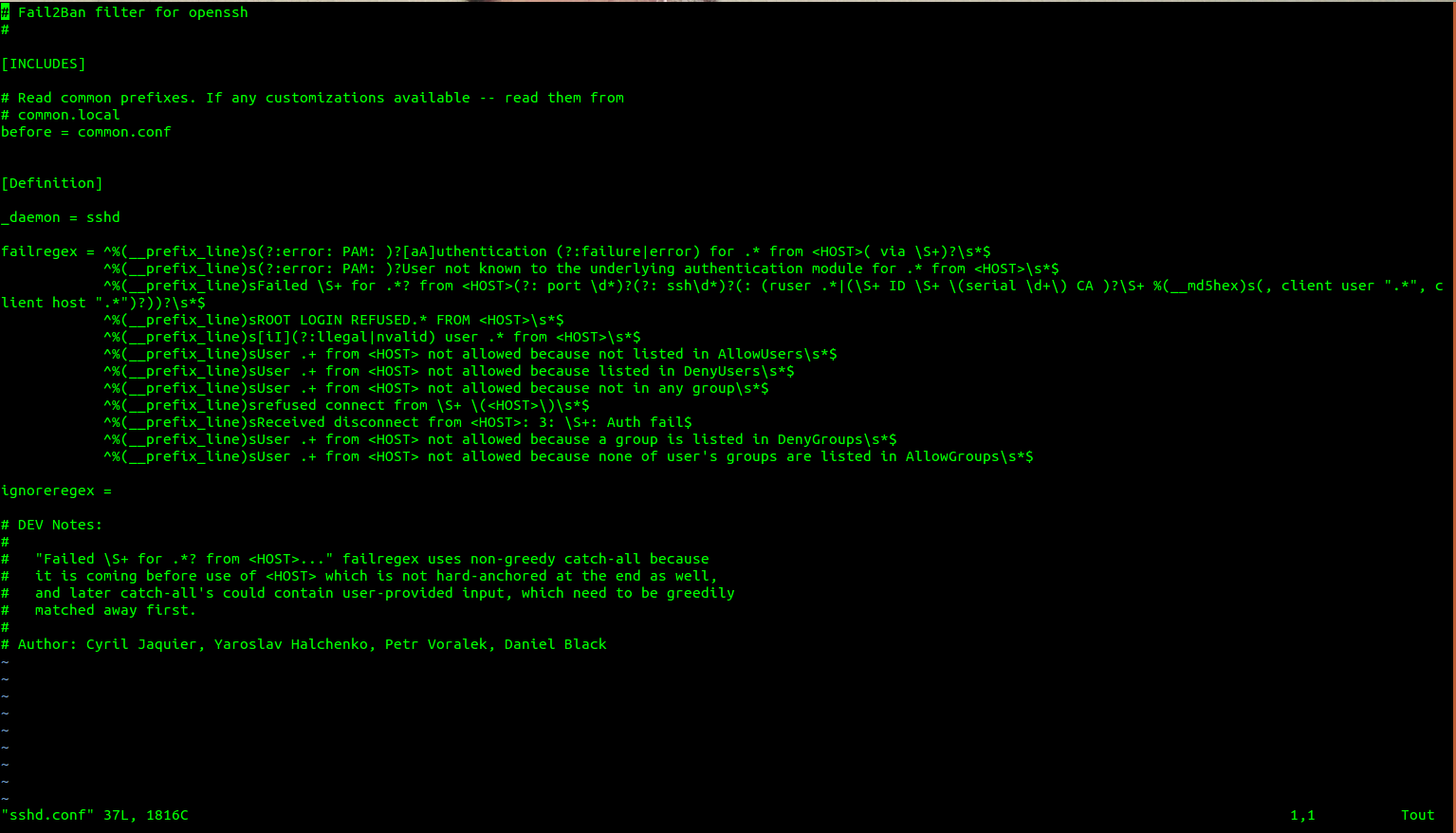

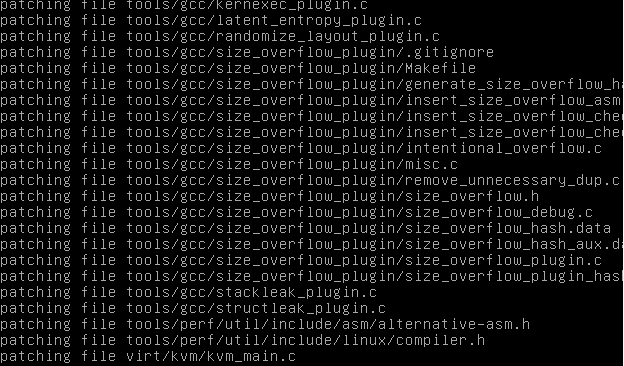

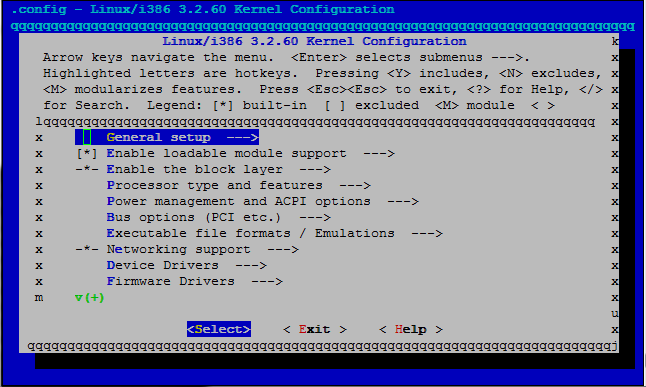

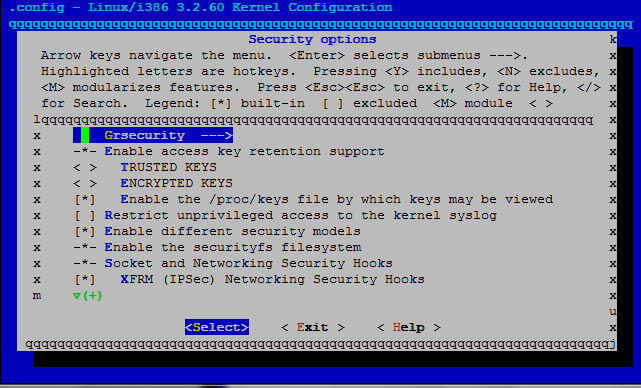

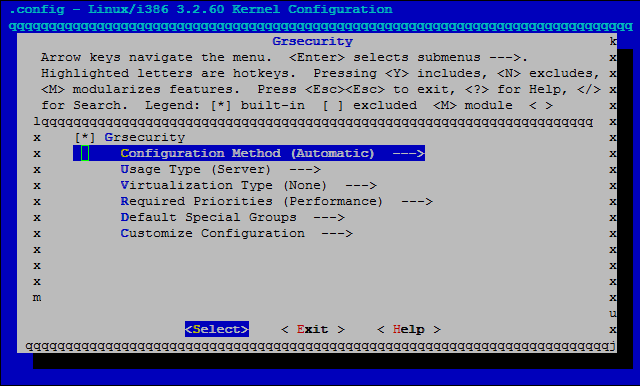

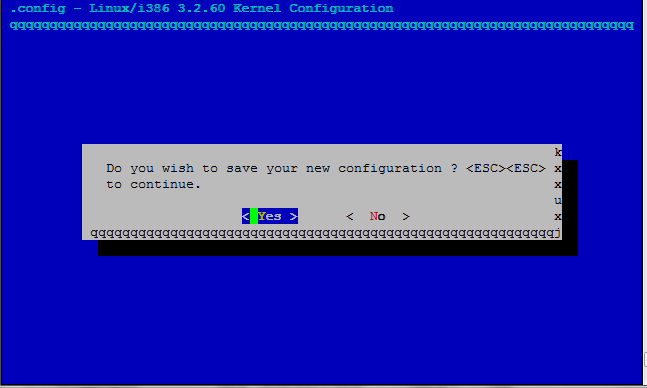

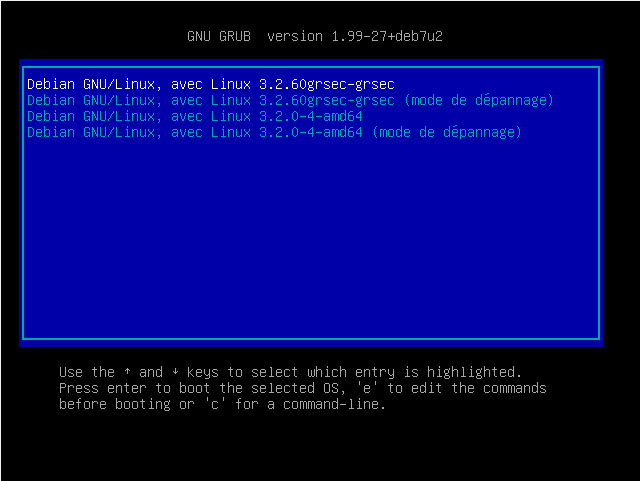

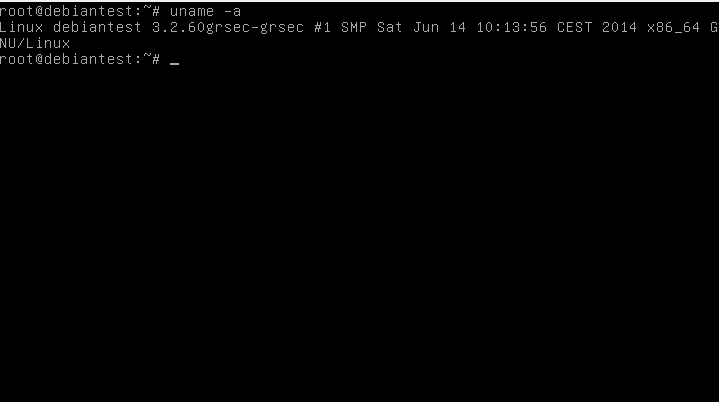

J’ai choisis la méthode automatique afin de faciliter la compréhension de ce tutoriel, mais rien ne vous empêche de bidouiller un peu afin de découvrir plus en détail les fonctionnalités incroyables de GRSec!

J’ai choisis la méthode automatique afin de faciliter la compréhension de ce tutoriel, mais rien ne vous empêche de bidouiller un peu afin de découvrir plus en détail les fonctionnalités incroyables de GRSec!

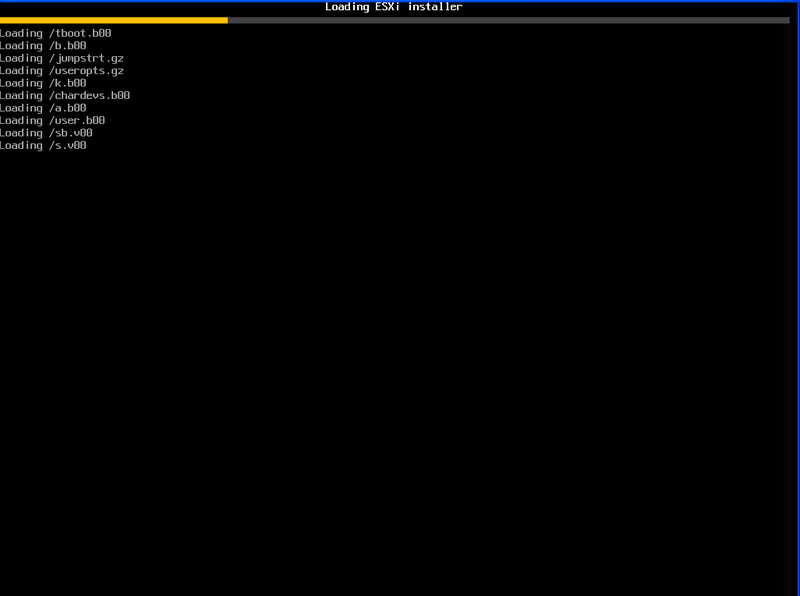

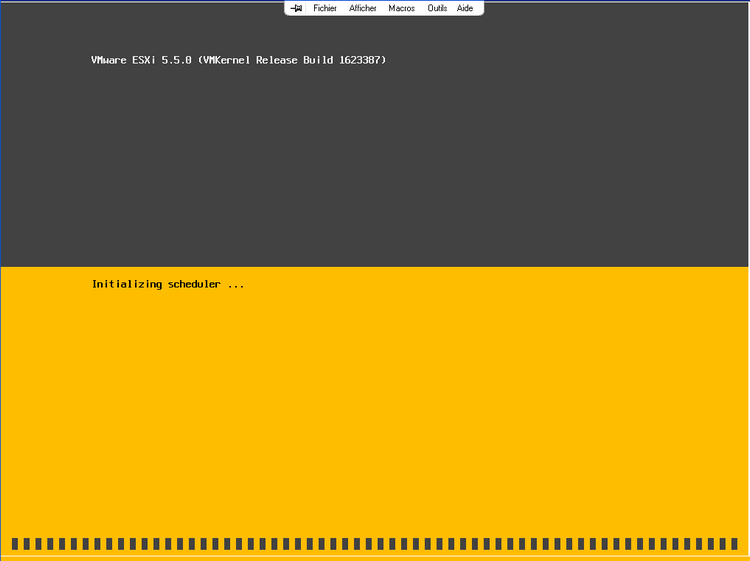

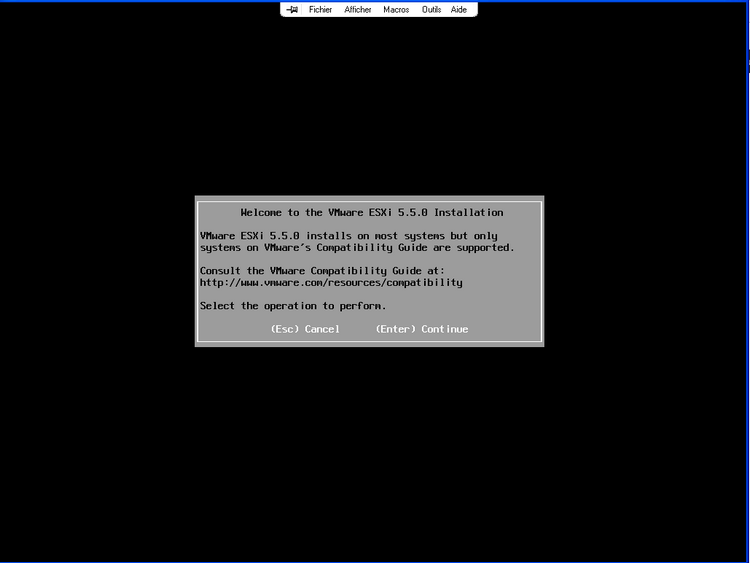

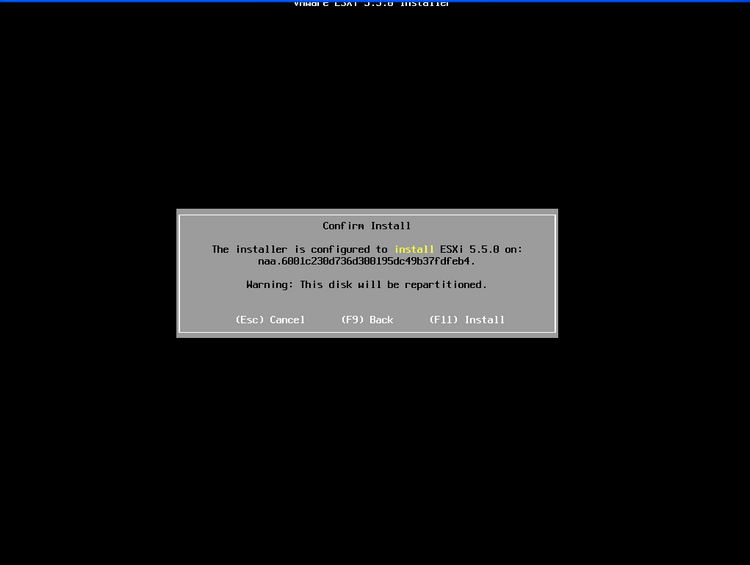

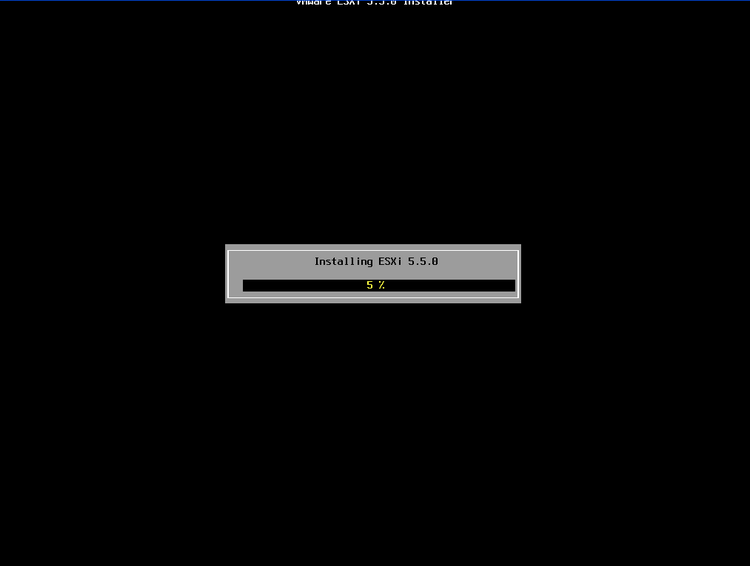

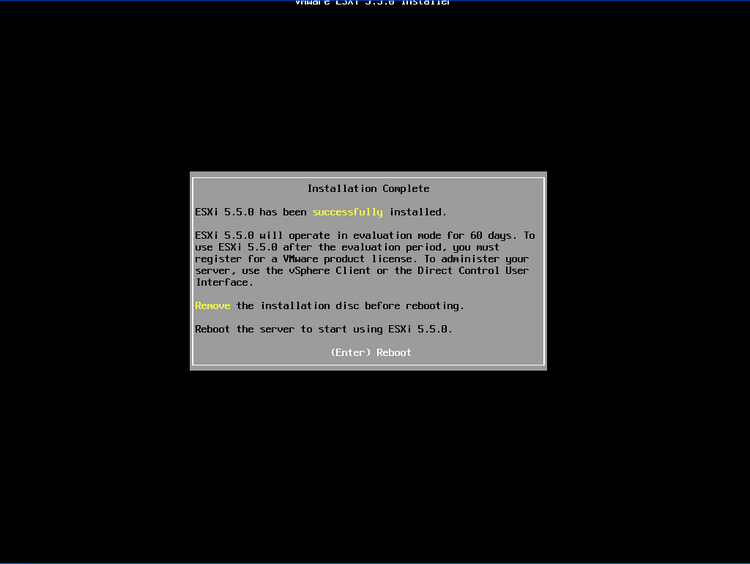

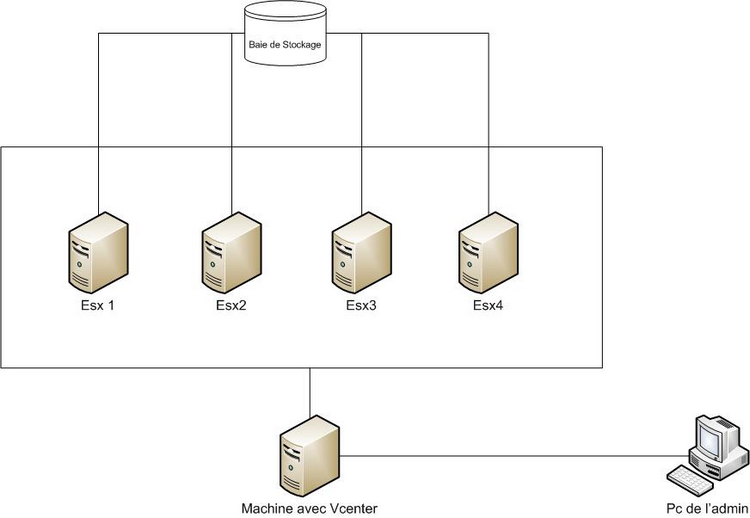

Attention vérifiez l’activation de INTEL VT dans les paramètres CPU du BIOS de votre serveur

Attention vérifiez l’activation de INTEL VT dans les paramètres CPU du BIOS de votre serveur

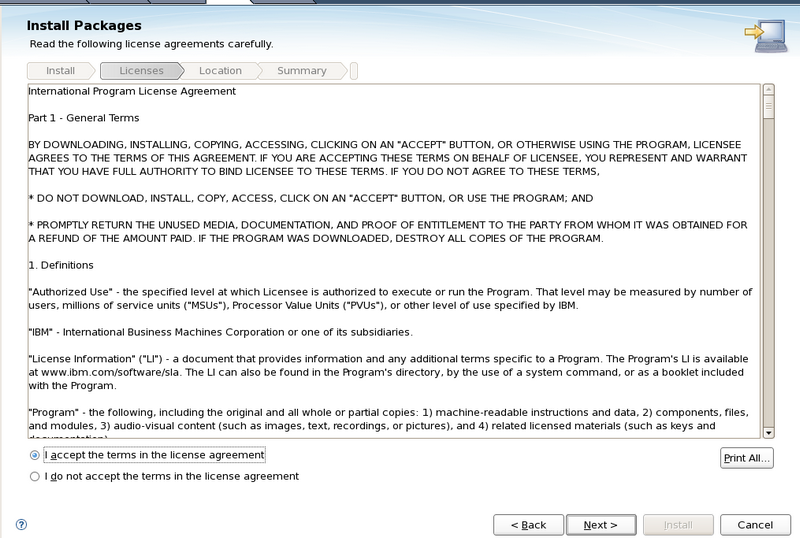

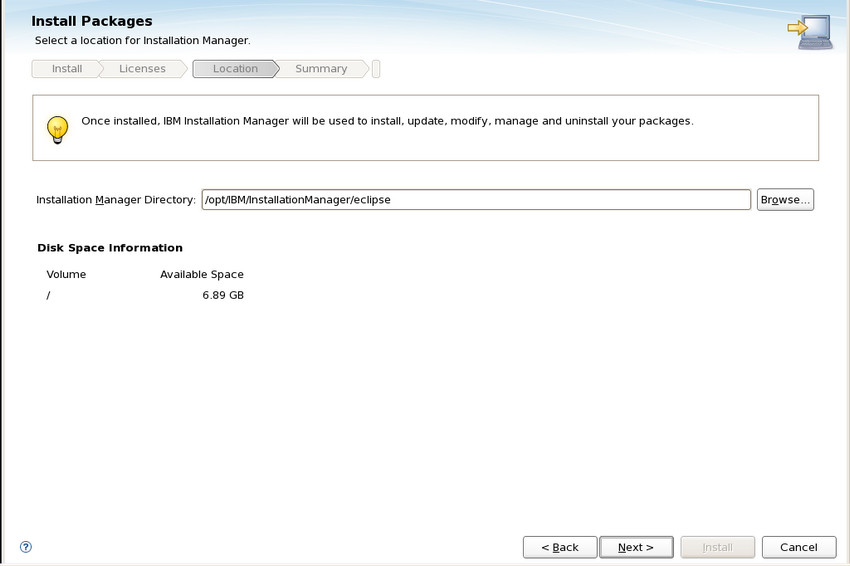

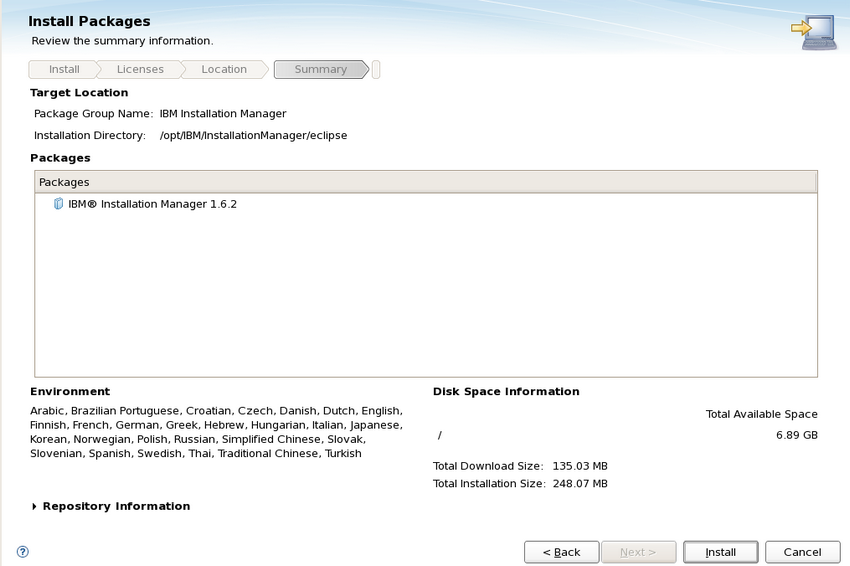

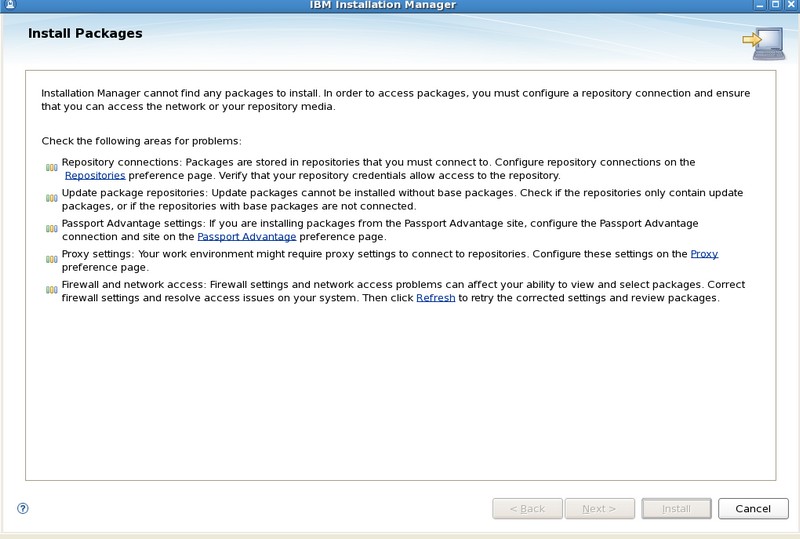

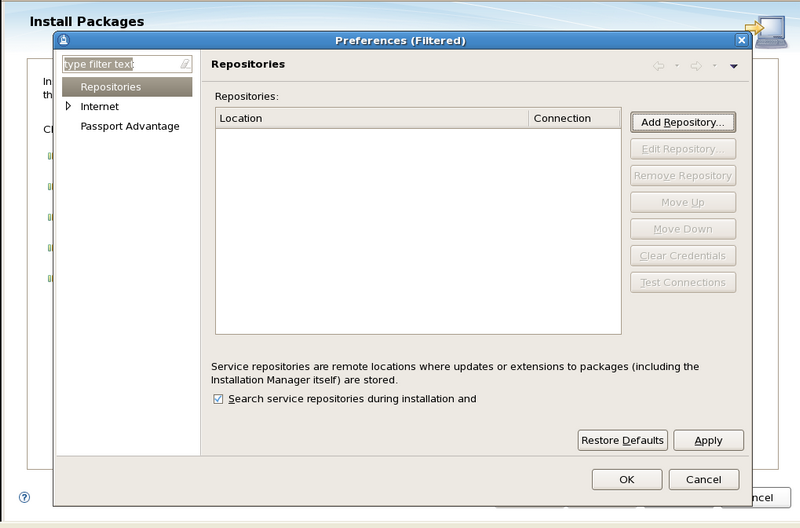

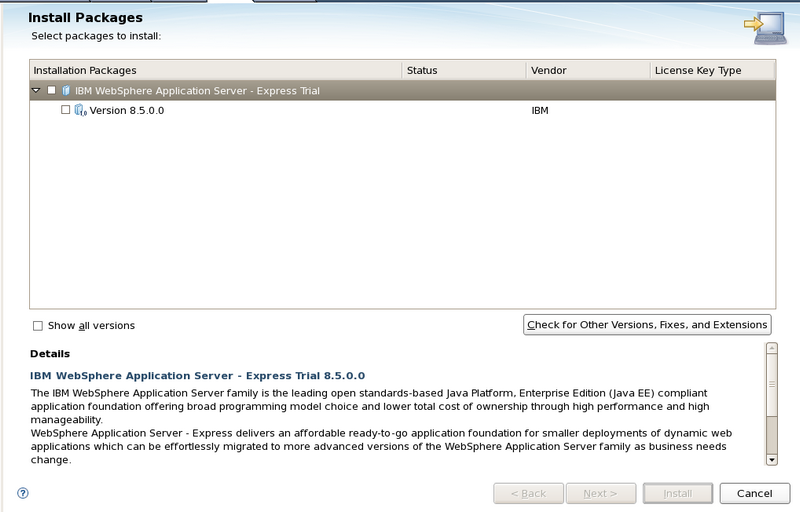

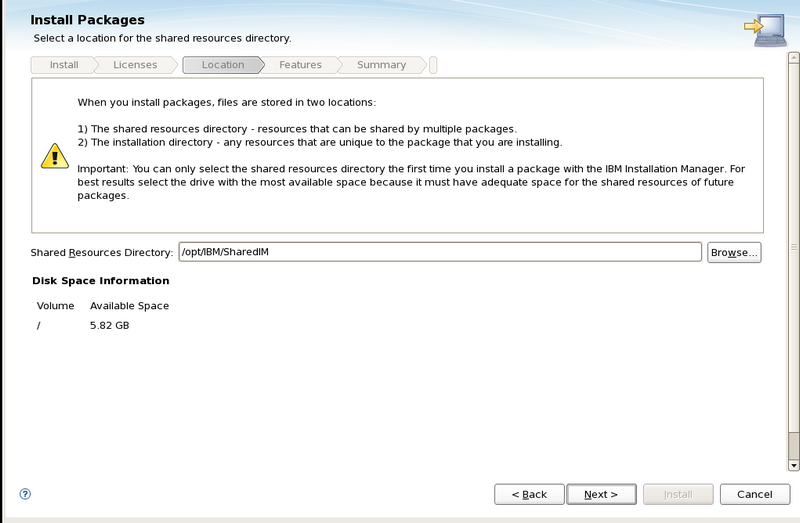

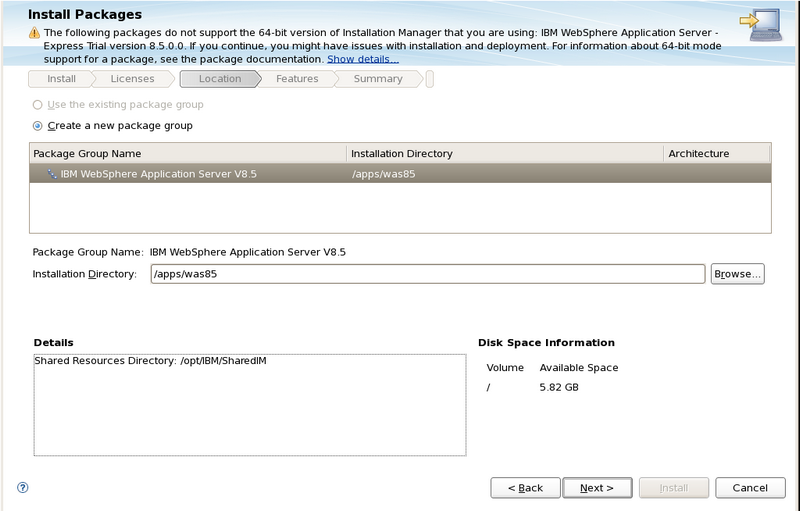

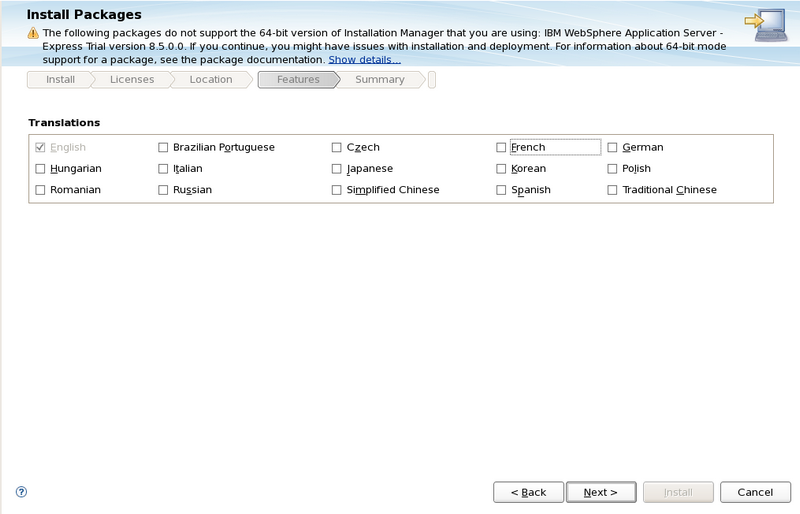

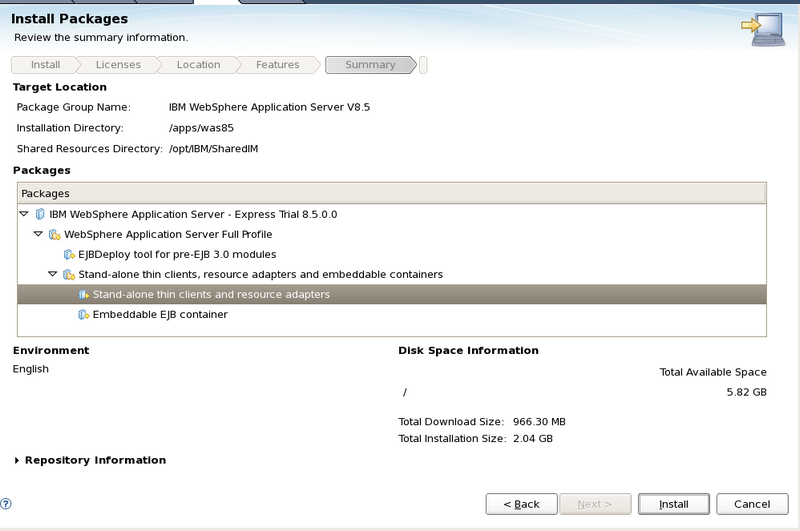

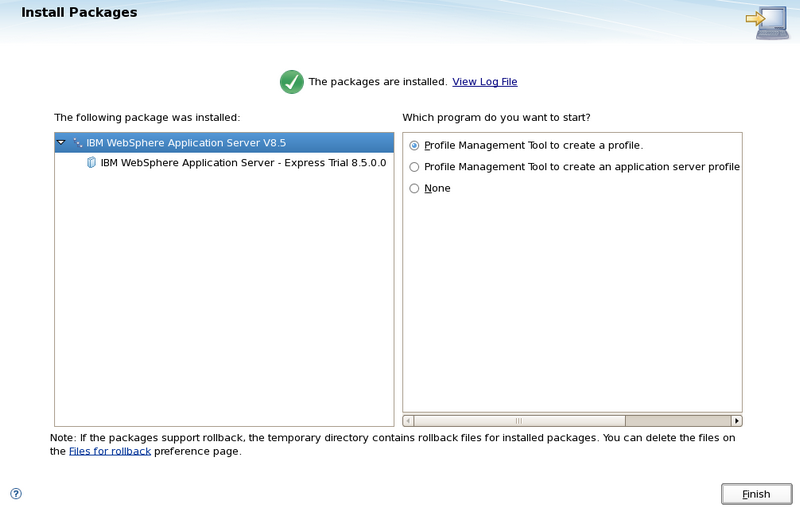

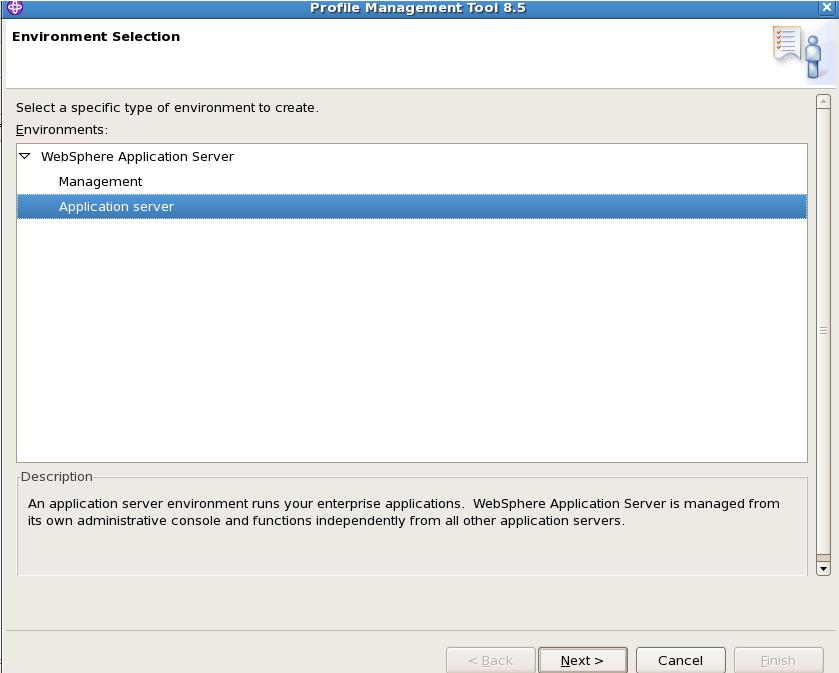

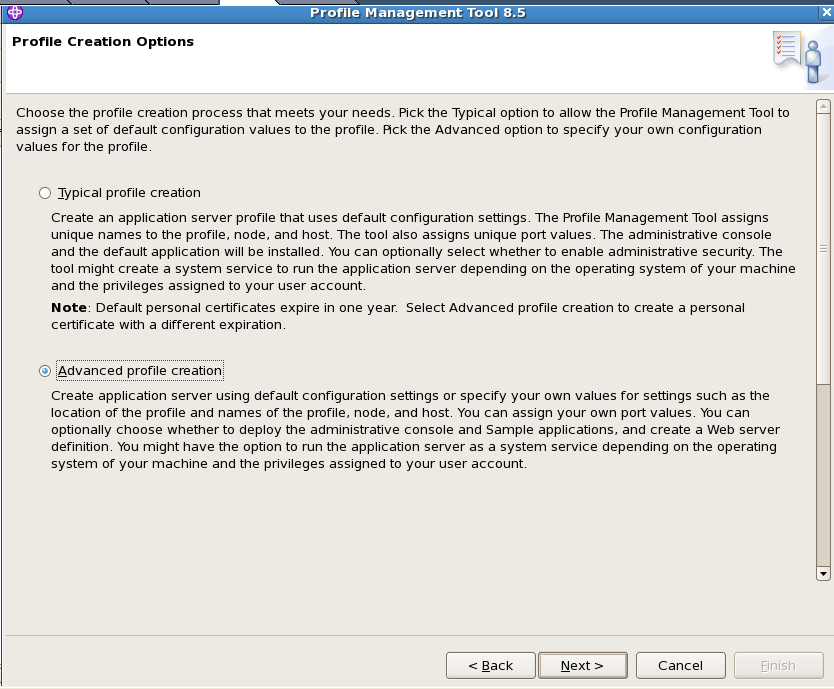

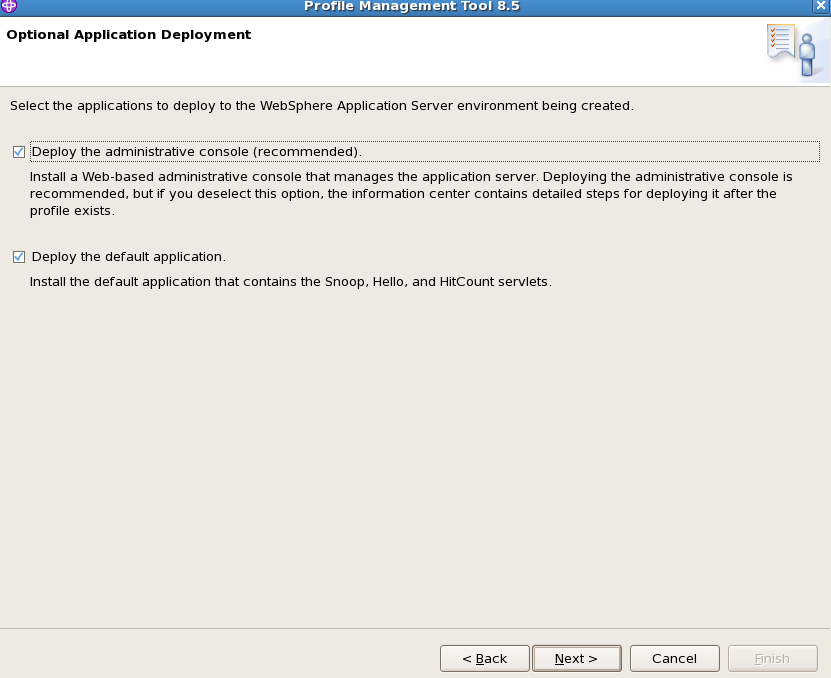

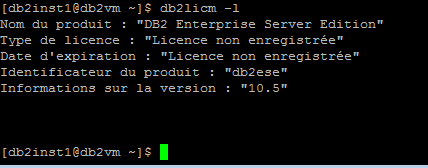

Je vous rappelle que WAS est une solution propriétaire. Il est nécessaire que vous soyez en règle coté licence. Cependant IBM propose une version d’évaluation limitée à 30 jours.

Je vous rappelle que WAS est une solution propriétaire. Il est nécessaire que vous soyez en règle coté licence. Cependant IBM propose une version d’évaluation limitée à 30 jours.